Google пошла по стопам Apple

Фотолюбители в восторге!

Американская корпорация из Маунтин-Вью создает новое поколение мобильных чипов, которые помогут смартфонам делать фотографии лучше.

Знали вы, или нет - обычно под капотом телефона происходит много чего интересного, когда нажимаешь кнопку «Снять».

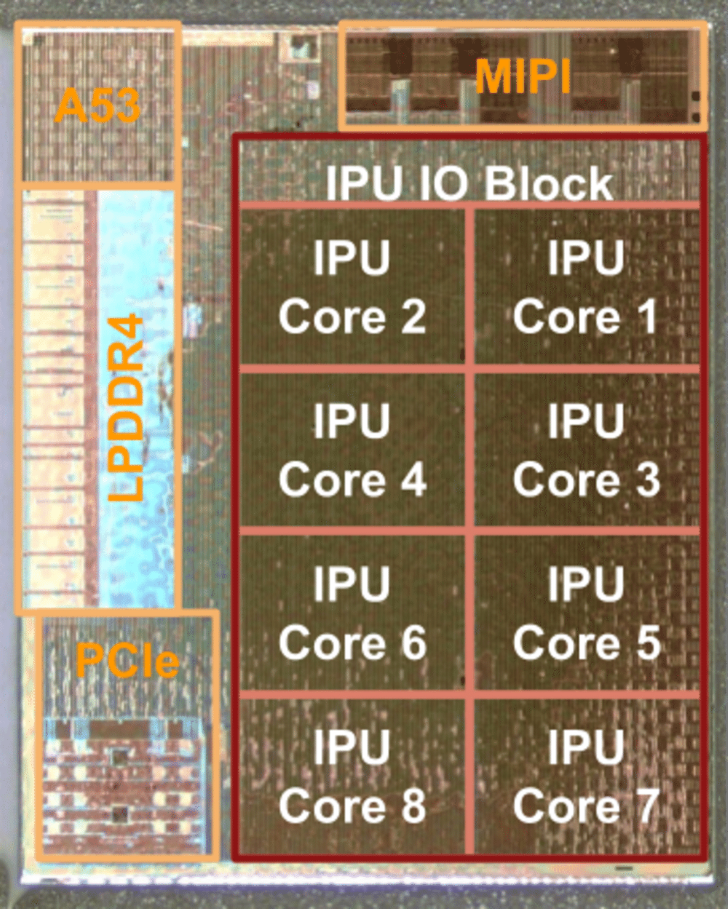

Процессор Pixel Visual Core.

Процессор Pixel Visual Core.

Всё становится куда интереснее, если устройство оснащено двойным модулем основной камеры - многие современные производители пошли по этому пути.

Но у ребят из Google свой взгляд на вещи, потому что их фирменный Pixel 2 пропустил эту стадию в своей эволюции - у него всего одна «большая» камера. Но есть секрет.

Как известно, смартфоны Pixel 2 содержат специальный процессор обработки изображений Pixel Visual Core, который Google разрабатывала совместно с Intel.

Зачем это нужно?

В былые времена опытный фотограф, глядя на снимок, мог точно определить, на какую плёнку был сделан кадр.

Мы не думаем об этом сегодня.

В наш цифровой век программное обеспечение смартфонов содержат алгоритмы, которые призваны воссоздать качество и эстетику плёночной фотографии.

Новый Google Pixel 2 использует именно такие алгоритмы, а также выделенный процессор изображений, чтобы придать «фоткам» стиль.

Вывели в цифру

Мобильная фотография все больше зависит от алгоритмов и чипсетов, которые реализуют сам процесс, поэтому Google сосредоточил огромные усилия в этой сфере.

Во-первых, камера Pixel 2 разработана командой инженеров, которые также являются фотографами: это они решают, как будут выглядеть фотки на «Андроиде».

Акцент делается на яркие цвета, высокую резкость и чёткость объектов в кадре.

«Я могу абсолютно точно узнать фото, сделанное на Pixel 2, просто посмотрев на снимок», - говорит Исаак Рейнольдс, менеджер проектов в команде разработчиков смартфона Google.

Во-вторых, они решили использовать отдельный чип Pixel Visual Core, необходимый для обработки изображений и машинного обучения.

Творчество других

Эта фотография сделана на камеру Google Pixel 2 в сложных условиях съёмки.

Кстати, получился очень неплохой снимок - насыщенная цветопередача, отсутствие шумов, приемлемый баланс белого и эффект размытия на заднем плане.

В новой версии ОС Android даже можно не включать режим HDR+, приложение камеры всё сделает за вас.

Сравнительный анализ

Чтобы понять, как работают алгоритмы, сравним два фото.

Картинка ниже сделана на телефон Google Pixel 2 с использованием стандартного Android-приложения камеры: насыщенное синее небо и контрастность.

Обратите внимание, как происходит передача деталей на темных участках снимка (телеграфный столб).

Следующее изображение снято через приложение Lightroom Mobile, графический редактор и менеджер фотоколлекций компании Adobe Systems.

В этой программе есть метод съемки в HDR-режиме, когда три кадра делаются с разной экспозицией (позволяет захватить как самые светлые участки, там и темные тени), после чего склеиваются в один файл в формате RAW.

Отснятый материал сохраняется в «сыром» RAW-формате, который содержит необработанные данные, полученные с фотоматрицы.

RAW-файлы, хоть и «весят» значительно больше, чем JPG, дают намного более широкие возможности для обработки получившегося снимка. В них можно, к примеру, откорректировать экспозицию и баланс белого, контраст, а также настроить яркость и уровень шума.

Функционал даёт больше простора для творческой обработки снимка, подавляет шумы и устанавливает тональные значения, чтобы придать изображению естественный вид.

В Lightroom используется проприетарный формат Adobe - «цифровой негатив» DNG, что очень требовательно к «железу» и работает только на мощных смартфонах.

На Android новый режим доступен на Google Pixel и Pixel XL. Кроме того, функцией съемки в RAW уже давно обладают «Айфоны» и «Самсунги».

![]()